Blog

Cristian Muñoz

DIT egresado del Atelier XXXX en línea.

Tras terminar sus estudios como Ingeniero Técnico de Telecomunicaciones en la Universidad de Alcalá de Henares (UAH), en 2021 se diploma como Director de Fotografía en el Instituto de Cine de Madrid (ICM), desarrollando su interés por los procesos técnicos en cámaras cinematográficas.

A partir de entonces, ha ejercido de ayudante de cámara en diversos cortometrajes de ficción y videoclips, trabajando con las principales cámaras digitales (RED, ARRI) así como analógicas (ARRIFLEX).

Por su cuenta y riesgo, ha realizado videoclips para bandas y músicos amigos, así como cortometrajes de boda, aplicándoles una pátina de ficción alejada del estándar actual en este tipo de producciones. En todos ellos, se ha encargado de gran parte de los procesos creativos y técnicos del mismo, desde el guión y dirección hasta la edición y color grading. Ahora se encuentra en proceso de distribución de su primer cortometraje documental sobre el mundo del coleccionismo musical y el crate diggin', inspirado en sus propias experiencias que se editarán en papel próximamente.

En paralelo, su interés por la técnica cinematográfica se materializa con sus estudios de ColorPlan especializados en DIT, centrando en la actualidad todos sus esfuerzos y un constante aprendizaje gracias a su gusto por las labores on-set y el trabajo colectivo que conlleva.

“Estoy agradecido de que impartas un curso con el nivel de exigencia y de información como ninguno, al menos en español. Es un trabajo exhaustivo que por mi parte valoro sobre todo por la manera en que lo explicas. Para mí encontrarme a alguien que habla en mi mismo "idioma" técnico ha sido una revelación, tan necesaria como difícil de encontrar. Has conseguido que al menos me crea que puedo ser parte de un rodaje como D.I.T. o Data Wrangler. Ahora ya queda continuar aprendiendo a partir de esta base.”.

Observaciones de Edi Walger:

Excelente examen, destacando además que estudió a través del curso grabado con gran atención a los detalles técnicos.

Tomó el curso online desde España

CV completo en Linkedin

Les comparto aquí el último video público sobre ACES 2.0 que hice junto a Daniel Bañuelos, docente y colega que va a dictar en CDMX un curso de Asistencia de Color.

Esta nueva versión de ACES cambia la RRT, lo cual repercute en todas las ODT.

Además se expande la utilización del ACES Metadata File, agregando implementaciones que facilitan la automatización y seguimiento de transformaciones de color.

El cine nació como un arte y como un formato a la vez.

Su aspecto visual enamoró desde el principio de su historia. Y muchos han quedado flechados por ese primer amor.

En escalas temporales diferentes, este flechazo sucede durante toda la cadena de producción cinematográfica.

La monitorización en campo muestra por primera vez una imagen cinematográfica, y ese monitor generará una primera impresión imborrable en todos los realizadores.

A su vez, todo el material rodado se visualizará tempranamente a través de representaciones de menor calidad generadas "a diario", para evaluar las acciones dramáticas y encuadres por sobre los resultados de la fotografía, aunque no todos son capaces de abstraer del todo lo que deben observar en la imagen y terminarán siendo seducidos por la apariencia de estos "dailies". Luego, durante el proceso de edición, el director y productores estarán enamorándose del material filmado, mirando sin embargo una representación del material rodado que muestra sólo una parte de su riqueza visual.

En este contexto, el HDR se introduce como un formato problemático, pues para enamorarse de el exigiría una monitorización en campo, dailies y edición que muestre el formato de entrega HDR que en general se visualizará adecuadamente sólo durante la sesión de color grading, lo cual es un compromiso técnico dificil de cumplir pues en general las salas de color poseen tecnologías de visualización muy superiores a las que se pueden conseguir en set, a través de dispositivos móviles que soporten HDR para revisiones, o en las salas de edición.

Las recomendaciones acerca de comenzar la sesión de grading visualizando HDR traerá además resistencias en los realizadores que ya han sido flechados por el formato fotoquímico, con la consecuente pérdida de entusiasmo al tener que realizar el trabajo de color desde un formato visual menos querido, posponiendo la sesión SDR recién al último día de trabajo de color.

El HDR traerá además algunos problemas al mantener una cadencia constante de cuadros por segundo, pero aumentando considerablemente el tamaño de los displays domésticos y además el contraste, lo cual produce una visualización incómoda en la fluidez de movimiento, en forma de "tironeo" incluso en escenas de movimiento y contraste moderado.

Las herramientas de conversión HDR a SDR de Dolby proponen además un "ajuste automático" plano por plano como punto de partida, el cual suele forzar una "continuidad" que no condice con el propósito artístico de cada escena. El análisis automático acomodará de manera similar a un "contraste dinámico" cada evento de una escena dentro de un monitor SDR, rompiendo muchas veces con la coherencia narrativa obtenida por el colorista en la sesión de grading HDR.

Puede entonces ser mejor idea utilizar un análisis Dolby del "hero shot" de cada escena y utilizar ese metadato para el total de eventos que la componen, y desde allí verificar si vale la pena realizar ajustes manuales de los planos que lo requieran.

Pero esto es sólo un truco válido para reducir la entrega a un sólo máster acompañado de metadatos, sin resolver un problema de fondo: todo el flujo de trabajo que exige monitorización HDR plantea una forma ideal de trabajo que va en contra del primigenio enamoramiento con la imagen cinematográfica.

¿Habrá planteos técnicos que puedan mantener esa relación amorosa, nacida del flechazo original que produjo el cine en todos sus realizadores?

¿Sería posible evitar que toda la cadena de producción deba migrar a HDR, implementando un flujo de trabajo constante en SDR para monitorización en campo, dailies, edición, VFx, revisiones y primer grading?

Si una parte del trabajo de grading es la compresión tonal del "shoulder", o dicho en otro spanglish "realizar el rolloff de los highlights" ¿Esa tarea podría realizarse de manera independiente a otras, de manera tal de poder "apagarla" al momento de realizar el último grade en HDR?

De esta manera, el "formato extra" que implica el HDR perdería su lugar central en la cadena, aunque repercuta negativamente en las ventas de displays HDR dedicados para cada eslabón de la producción audiovisual, dejándolo recién para una masterización final.

El último formato quedaría entonces para lo último.

No suena tan injusto.

El debate ya fue abierto, pero en inglés. Aquí les dejo un video interesante al respecto:

La tradición de cómo se produjo el cine en Argentina tuvo un fuerte quiebre con la aparición de los Estudios, esta vez encarnados como plataformas. Aparecen los protocolos, dolores de cabeza para muchos técnicos de liviana formación académica, lo cual una vez aprendidos pueden convertirse incluso en métodos útiles de producción. Múltiples términos extranjerizantes surgen de una neolengua propia de la tecnología: Delivery, QC, Milestone, Watermark, Call, y tantos otros neologismos son ya parte aceptada de nuestro argot. Esto sucede en la superficie de un nuevo paradigma que se apropia también de la construcción de sentido.

Los directores de cine comienzan a ser monitorizados creativamente, con un “director de serie” denominado showrunner. Las adopciones metodológicas gringas impactan en la forma narrativa, e incluso en cómo se escribe la historia reciente de las naciones.

Una exigencia vigente es virtualizar la producción, a través de la utilización de un recurso tecnológico inmaduro en muchos de sus aspectos técnicos, que exige el abarcar un conocimiento integral de lo que antes se dividía en etapas: producción y post-producción.

Los VFx o efectos visuales exigen de una planificación en preproducción que condiciona al rodaje para su futura postproducción, por lo cual es un gran error pensar estas tareas como acotadas al final del proceso de realización audiovisual.

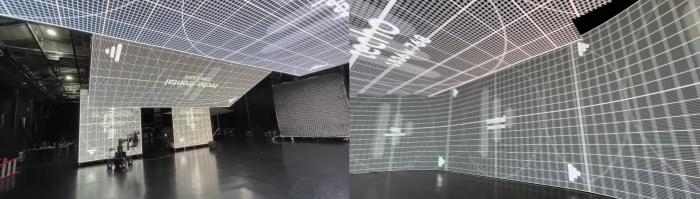

La producción virtual es un método para que los efectos visuales se produzcan delante de la misma cámara, y de allí el nuevo término ICVFx: In-camera Visual Effects, obliga a la producción a reorganizar etapas de la realización, e incluso duplicar algunas realizaciones que deberán ejecutarse en el mundo real y en el virtual.

Este mundo virtual se basa en el CGI, la imagen generada por computadora, en donde los artistas tradicionales de VFx deberán utilizar métodos de creación que poseen restricciones debido a la exigencia de plasmar imágenes en tiempo real. Utilizar la menor cantidad de polígonos y motores de render con materiales que no emulan totalmente la física de la luz atentan con el fotorrealismo que suele conseguirse fácilmente hoy en día con tecnologías aplicadas a VFx que no tienen la necesidad del tiempo real, el cual es condición sine qua non para la industria del videojuego.

Es por ello que los artistas consagrados en CGI de postproducción no son lo suficientemente expertos en la producción virtual, y los artistas que trabajaban en el área de videojuegos migran fácilmente a este tipo de producción, acostumbrados a los dolores de cabeza que implica economizar al extremo los recursos de cálculo informático.

Pero existe un gran obstáculo a superar, y es que aunque se utilizan tecnologías de render de menor calidad, el criterio de fotorrealismo que tienen los Estudios sigue siendo de la misma exigencia que el sostenido para el CGI de postproducción, enfrentando al artista de videojuego a una exigencia que a veces puede no comprender fácilmente.

Los directores de áreas importantes como Arte y Fotografía deberán entonces trabajar en la etapa de preproducción junto a estos artistas de CGI, pues mucha escenografía y utilería deberá realizarse e iluminarse virtualmente, e incluso por duplicado en el mundo real con apariencia idéntica.

El léxico utilizado en el mundo CGI no suele coincidir con la terminología que manejan estos directores, lo cual exige de un aprendizaje interdisciplinario que pocas personas ya poseen, como los Supervisores de VFx experimentados en áreas de CGI, composición y supervisión de rodaje. Esta formación mixta es ahora imprescindible también para los artistas de CGI, teniendo que ellos también comprender cómo se elabora creativamente la realización escenográfica y la iluminación. Esto trae un gran conflicto adicional con el Productor, pues deberá también estar abierto al drástico cambio en las reglas de juego, en donde necesitará a los directores muy involucrados en la preproducción, para llegar con los bienes o assets virtuales totalmente acabados para el momento del rodaje, el cual poseerá también sus propias dificultades.

Las pantallas LED hoy disponibles imponen muchas limitaciones en la calidad fotográfica, debido a la limitada potencia de la pantalla, las fallas metaméricas de iluminación LED RGB, y el bajo contraste que genera el volumen LED en donde los actores se introducen para engañar a la cámara. Por estar iluminados de manera envolvente, la iluminación pierde parte de su direccionalidad, lo cual repercute en la relación de contraste obtenible. Otro problema suele darse con el color que reflejan los objetos al ser iluminados por los volúmenes actuales, resultando en distorsiones visibles en el realce de saturación y las fallas en representar objetos amarillos.

Otro limitante es el rango de movimiento que permite el interior de estos volúmenes LED, además de los problemas de resolución limitada que poseen las pantallas, lo cual produce efecto Moiré al acercar a los actores a las pantallas o bien al utilizar ciertos sistemas ópticos. Además cada tipo de sensor necesitará de una calibración diferente en términos de color para minimizar distorsiones cromáticas, lo cual deberá también ser evaluado con anticipación para no encontrar estos problemas al momento de rodar.

La planificación tanto técnica como artística es entonces el momento clave para los ICVFx, dejando reservada la improvisación para los actores, lo cual puede chocar con la forma de llevar adelante el rodaje para muchos directores de cine y series.

Mi invitación es anticiparse a estos desafíos a través del estudio de las condiciones que impone hoy la producción virtual, sumergiendo a productores, directores, directores de fotografía y directores de arte al mundo del CGI y a las tecnologías de captura y reproducción color LED hoy disponibles.

Edi Walger

La "captura" de la luz.

La luz es energía libre, por lo cual la expresión captura de la luz es un oxímoron. Sin embargo es posible capturar una Imagen, la cual es una representación de la realidad que se consigue a través del principio de transducción, en donde la magnitud física de la luz se transforma en otra, la cual es susceptible de retener en forma material.

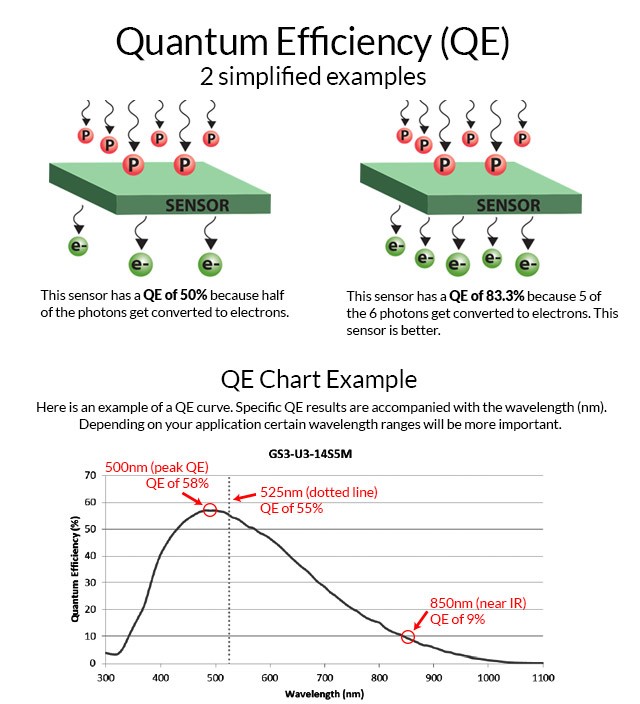

El efecto fotoeléctrico explica un fenómeno natural en donde la luz es capaz de liberar electrones de una estructura atómica determinada.

Todo sensor digital se explica desde este primer fenómeno, el cual conviene comprender un poco más en profundidad, especialmente para técnicos de imagen digital. Una característica de este efecto que por lo tanto rige a todo sensor es que un material fotoeléctrico libera una cantidad de electricidad que es proporcional a la luz, pero no de manera directa sino lineal. Por ejemplo 100 fotones pueden liberar 50 electrones, o sea una eficiencia cuántica que puede expresarse en 50%, sin importar a qué cantidad de fotones nos referimos.

Sin embargo la eficiencia cuántica del efecto fotoeléctrico no es igual para cada longitud de onda del espectro electromagnético, lo cual define una respuesta espectral diferente para cada tipo de sensor de acuerdo a su constitución.

Los electrones liberados pueden encauzarse en una corriente eléctrica, la cual es un voltaje que fluctúa de acuerdo a la intensidad de la luz, en una proporción lineal.

Por otra parte, el sistema visual humano es parte del sistema nervioso, el cual transmite por sus nervios y neuronas energía eléctrica. Frente a un estímulo de luz, el sistema visual no genera una bioelectricidad que guarde una proporción lineal con esta luz, y su complejidad impide aún el establecer una proporción no lineal expresada en términos matemáticos.

Por otro lado existen emisores de luz capaces de ser excitados mediante la electricidad, y estos también poseen su propia eficiencia y de acuerdo a la tecnología pueden emitir una cantidad de luz en proporción lineal al voltaje, dispositivos los cuales son los de “referencia” gracias a su nobleza en su funcionamiento.

El problema inicial es entonces crear señales eléctricas proporcionales a la luz y no a la percepción de esa luz, con el objetivo de utilizar un voltaje mínimo que represente lo que percibimos como brillo.

La escena lumínica, en donde sucede la acción de la luz sobre los objetos, es entonces representada por un voltaje capaz de transducirse a luz al final de una cadena de señales de video.

La fotoquímica no lineal

Otra manera de capturar una imagen es utilizar materiales que sean fotosensibles y que cambien su constitución molecular al liberar electrones estableciendo una reacción fotoquímica

La emulsión de haluros de plata permite este fenómeno, el cual no guardará una proporción lineal con la cantidad de luz a la que fue expuesta.

Aunque no es parecida a la respuesta sensorial de nuestro sistema visual, a lo largo de años de experimentación química se han logrado resultados que han definido un canon estético de cómo representar una imagen.

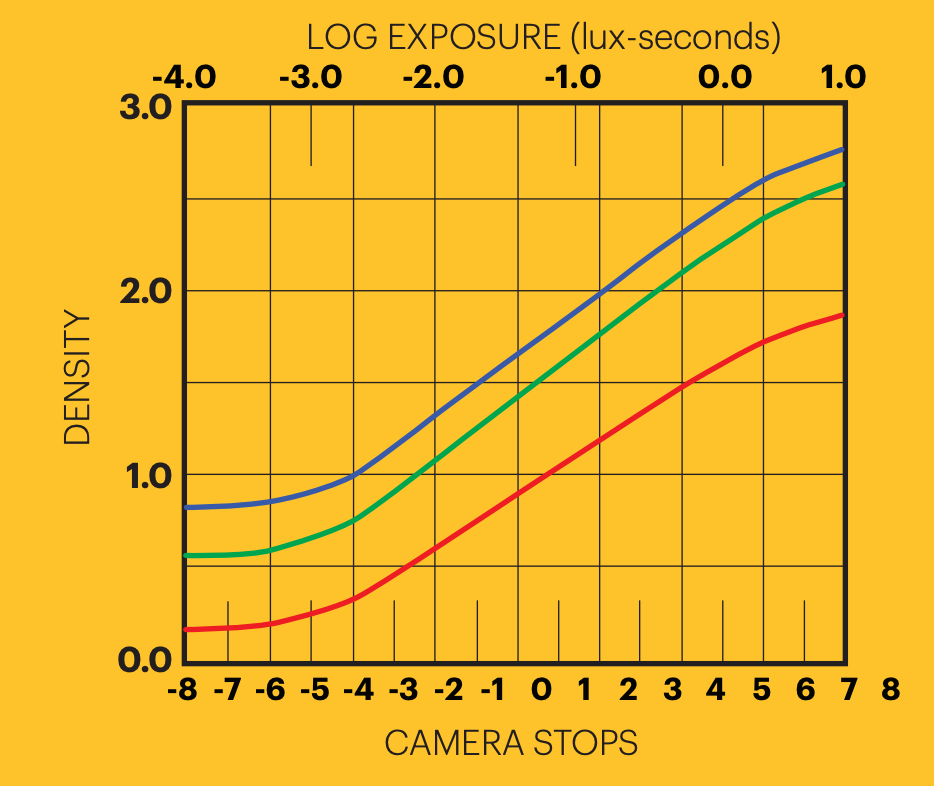

En los procesos fotoquímicos iniciales, la imagen latente es revelada en un proceso posterior por el cual el haluro que ha reaccionado a la luz pasa a ser opaco, mientras el resto de haluros menos expuestos podrán ser eliminados durante el proceso. Esto establece una relación entre la luz de la escena y opacidades que no guardan entonces una relación lineal, y para estudiar esta relación se han establecido valores que representen unidades en una escala logarítmica con base 10, tanto para medir una cantidad de tiempo/valor de exposición versus una opacidad logarítmica, dando lugar a una unidad nueva llamada Densidad.

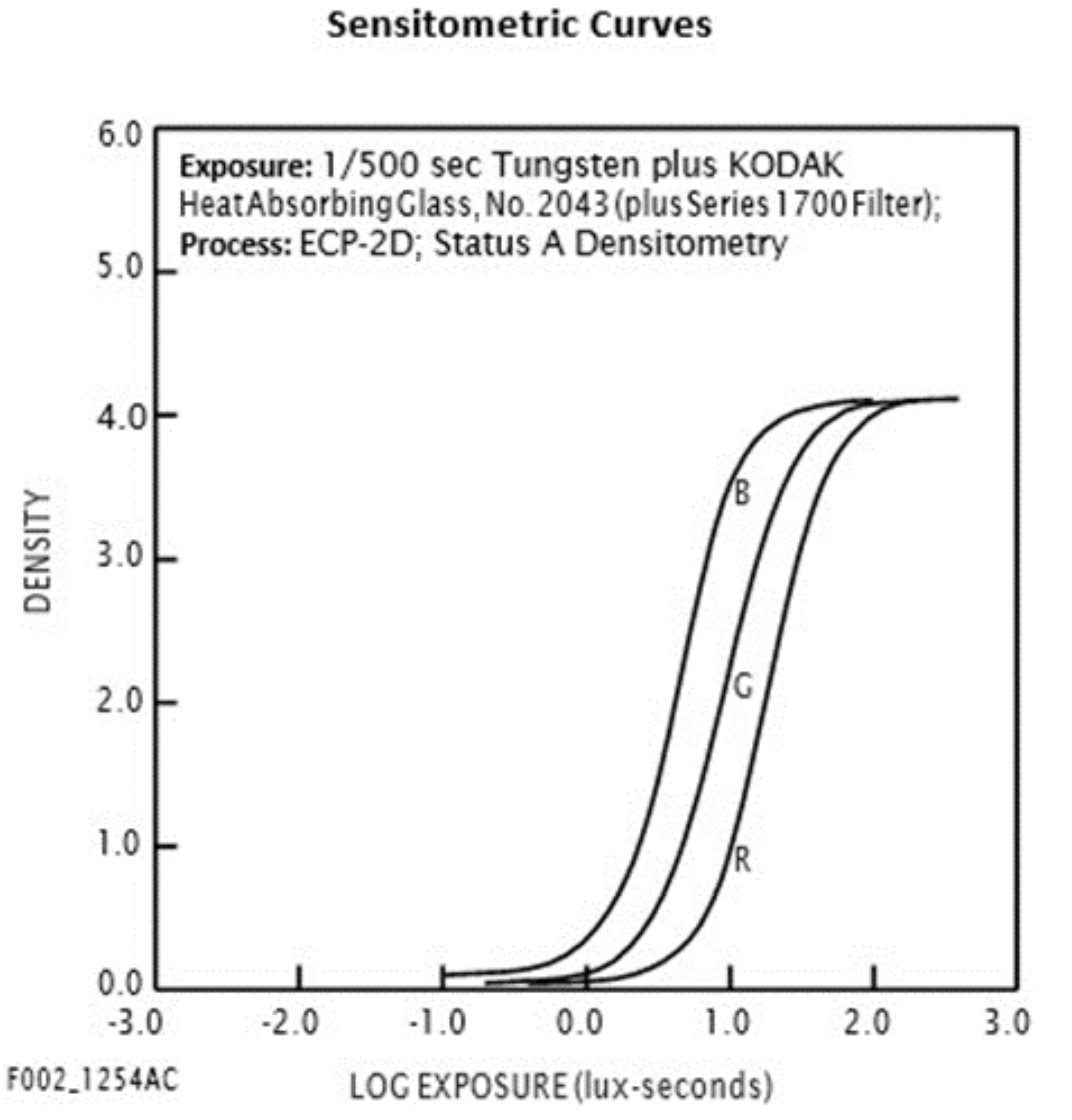

Un Densitómetro será un dispositivo fotoeléctrico que expresara valores en esta escala, y se podrá utilizar para estudiar esta relación no lineal, resultando en una función expresada en los ejes exposición/densidad una curva en vez de una recta lineal, conocida como la curva característica del soporte fotoquímico.

Será la porción central lineal de la curva lo más preciado para exponer imágenes, debido a que puede representar las cantidades de luz de manera fiel, pero esta porción puede representar una cantidad bastante limitada de contrastes.

En fotografía la escala por excelencia es la que define una relación logarítmica con base 2 (y no 10 como en la densitometría, aunque el 2 puede expresarse en esa escala con el valor 0.3). Esta escala define pasos o en inglés stops de incrementos de a doble o mitad, los cuales son traducibles a una escala de valores de exposición, los cuales puede traducirse a superficies de orificio para la cámara en relación a la longitud focal, a través del famoso número f, o en incrementos de tiempo de exposición.

Dentro de la línea recta de la curva sensitométrica caben pocos stops, pero los suficientes para representar detalle en un rango de claroscuros.

El pequeño detalle

La ambición del arte es la de a través de estímulos provocar sensaciones en todos los sentidos posibles, transmitiendo así emociones, ideas y detonar el pensamiento, resultando en un goce estético similar o diferente al placer.

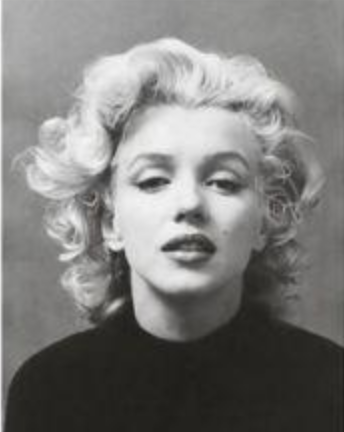

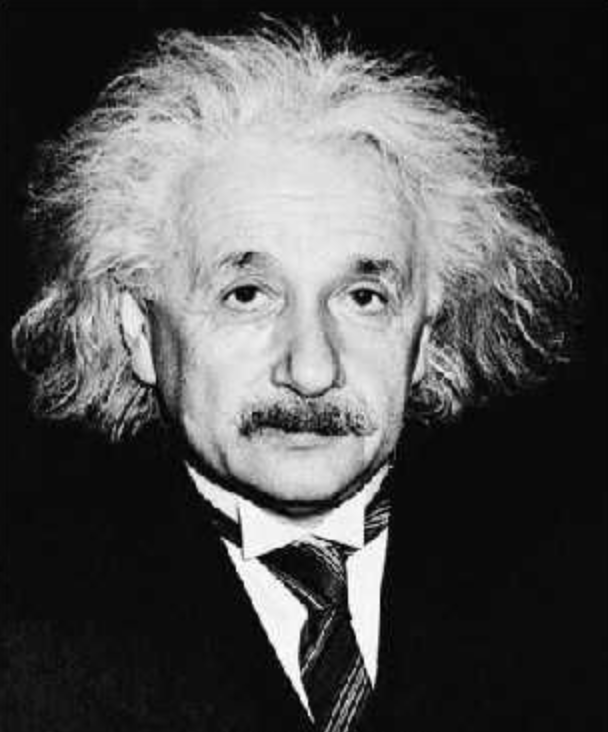

En sus inicios, la fotografia blanco y negro tuvo el desafio de compararse con el arte plástico, desplazando a retratistas con un simple ojo mecanico capaz de capturar imágenes.

Estas alcanzaron cierta reputación a medida que fueron capaces de representar tantos detalles como lo que se pueden alcanzar con un lápiz.

El detalle en blanco y negro puede asociarse no sólo con la nitidez, sino también con la capacidad de representar textura, la cual suele detonar una relación de sinestesia con el sentido del tacto, el cual es capaz de percibirla.

La representación fotográfica de algo conocido sin su textura de todas maneras puede disparar el goce estético, perdiendo los objetos y retratos una de sus características esenciales de su expresividad.

Adams

Fue Ansel Adams uno de los más preocupado en establecer un sistema que permita al fotógrafo conocer qué detalles de la escena serán o no representados en la captura de la imagen.

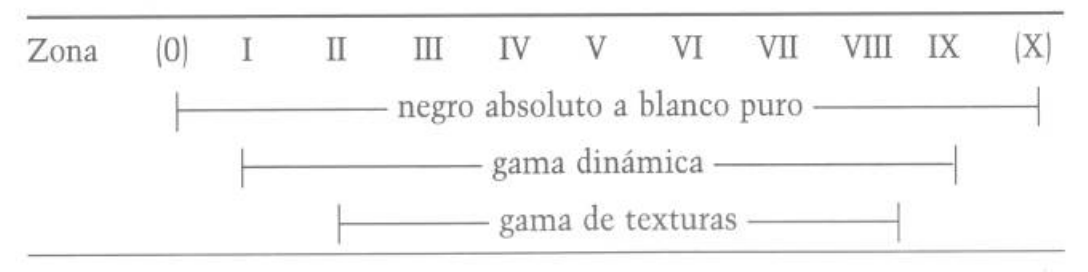

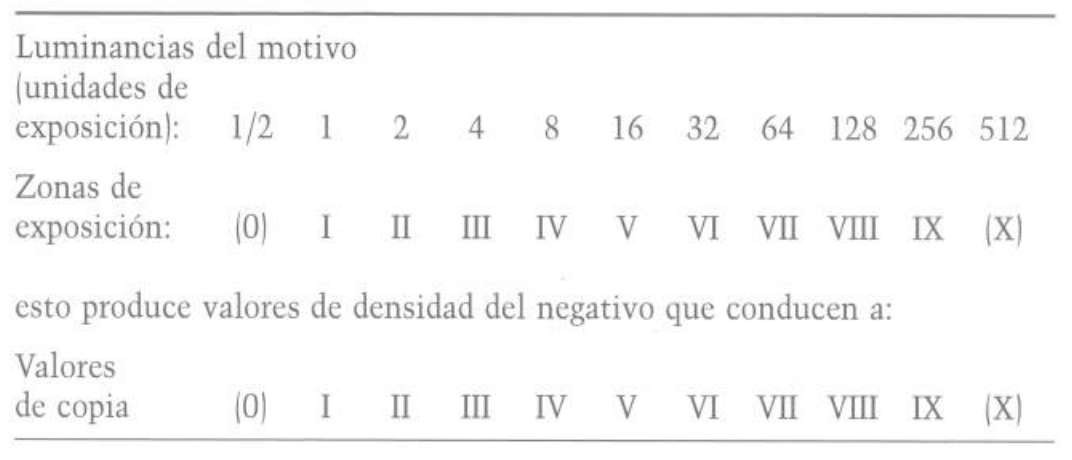

Para ello trazó una relación entre la fotografía impresa en papel y la escala de exposición, estableciendo una correspondencia entre stops o Zonas, y los Valores de grises de la copia impresa.

El papel posee una gran limitación de contraste, pues sin importar la cantidad de luz con la que fuera iluminado, al ser un sistema de reproducción sustractivo sólo puede absorber o reflejar luz. La reflexión especular de un papel no permitiría ver la impresión, por lo cual la base de este papel es un color blanco de reflexión lo suficientemente difusa como para no reconocer la fuente de luz reflejada en su superficie.

Lo más oscuro representable en un papel depende del tipo de técnica de impresión a utilizar. Si frente a una fuente de luz constante se toman medidas fotométricas, la relación entre lo más oscuro y lo más claro apenas desarrollará unos pocos stops, lo cual podríamos definir en cinco para poder establecer algún valor frecuente.

Al momento de la captura, estos valores de impresión deberán representar las Zonas del rango de luminancias medibles en la escena, las cuales en muchos casos como escenas diurnas poseen muchas más de las representables en el papel final.

En una pelicula blanco y negro, la cantidad de zonas representables son tambien limitadas, pero pueden alcanzar hasta 7 zonas y dentro de cada una representar el detalle de las texturas de cada objeto.

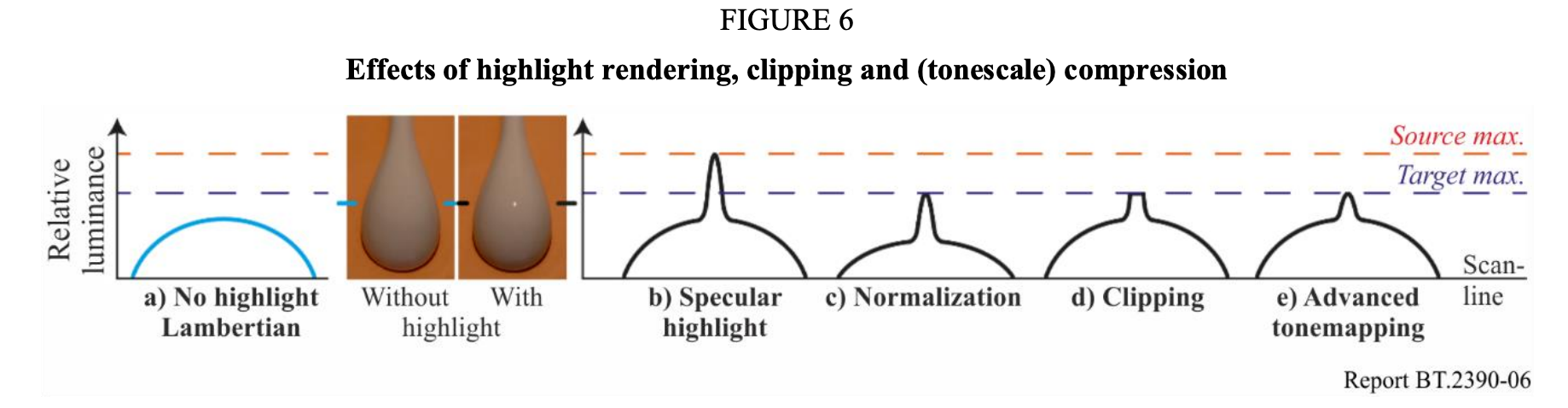

Adams hacía la distinción de tipo de reflectancia entre los objetos que participan en una escena bajo una sola fuente de luz, concentrando su atención en los de reflexión difusa pues los de reflexión especular reflejan una cantidad de luz muy elevada en relación a los objetos en sombras, lo cual excede cualquier posibilidad de usar las zonas de detalle de la película para semejante amplitud de luminosidad. Elige entonces no representar detalles de "especulares" y reservar las zonas de detalles para reflexiones difusas.

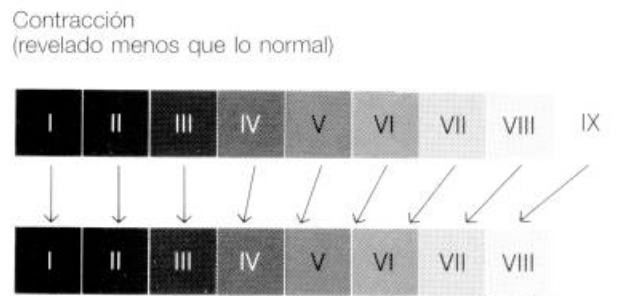

Con algunas técnicas en el proceso de revelado,Adams es también capaz de desplazar las zonas y comprimirlas o expandirlas, de acuerdo al tiempo o timing de uso del químico revelador, modificando así la relación de contraste de la escena al ser representada en una imagen de valores en papel.

Su Sistema Zonal servía entonces para razonar al momento de la captura, comprendiendo a través de la medición con un fotómetro cuales objetos o partes de estos podrán o no representar detalle, incluso utilizando sus métodos de compresión de laboratorio.

En toda esta explicación vale la pena aclarar de que el propio papel que positiva la imagen posee su propia respuesta no lineal, lo cual representa una nueva curva.

Lo mismo sucede con el positivo de proyección, incluso en los positivos más modernos de Kodak como el 2383.

Sus curvas distorsionarán siempre la representación de las zonas. Además otras limitaciones como el resplandor o flare que siempre sucede en el papel o en la pantalla blanca de cine afectará más a los tonos oscuros que a los claros.

SDR

En la televisión inicial, la relación de contraste de los televisores podrían representar seis o más stops, de acuerdo a su calidad tecnológica, pudiendo llegar incluso a diez en monitores de referencia. Pero la intensidad máxima de luminancia alcanzable por el dispositivo combinado con el flare de la pantalla de vidrio resultan siempre en una reducción final del contraste, sobre todo para el espectador final el cual usa su tv en un entorno con un grado de iluminación muy superior al utilizado en una oscura sala de cine.

La imagen canónica del cine llevó a la televisión a imitarla más de una vez, desde la proporción de imagen y también desde la representación de detalle.

Las TV inicialmente fueron pequeñas en relación a la pantalla de cine, y por lo tanto ocupaban una porción del campo visual muy pequeño, lo cual permite reproducir imágenes nítidas con relativamente poca definición.

En términos de detalle de textura, la tv eligió también representar reflexiones especulares con muy poco detalle, estableciendo en la emisión de luz del dispositivo un valor bastante alto para representar la reflexión difusa de un objeto blanco.

El objeto blanco es entonces el más claro de los objetos de reflexión difusa. El mas oscuro es el negro, pero un objeto blanco puede ser mas oscuro que uno negro si no recibe nada de luz. Es por ello que conviene pensar en los objetos “negros” y “blancos” de acuerdo a su Reflectancia y no a la cantidad de luz que reflejan que es su Luminancia.

Al mirar una TV, la reflectancia no existe, pues la imagen se forma desde la emisión de luz y no desde la absorción y reflexión.

Es entonces que el rango de claridades o lightness de las reflexiones difusas se representarán en valores de luminancia y no de reflectancia como en el papel fotográfico.

La claridad máxima corresponde al blanco difuso, y para lograr la ilusión de ver reflectancias, se establece para la tv un valor de adaptación a la luz, en donde si los objetos blancos se representan constantemente a determinado nivel de luminancia, el resto de valores serán percibidos en relación a este como si se trataran de valores en papel o en un medio sustractivo.

En la TV el 90% de la señal suele representar el rango de Claridad, mientras que el último 10% representara a los objetos de reflexión especular, o objetos brillantes más allá de lo claro, lo cual comprime la luminancia de la escena en pocos valores de luminancia del tv.

Existen escenas lumínicas con más de una fuente de luz donde una misma reflectancia de objeto puede retratarse con más de un nivel de luminancia, en donde el concepto de "especularidad" pierde sentido pues la reflexión difusa puede abarcar más que el rango de claridad, ese tipo de escenas son también analizables bajo este tipo de relaciones, abstrayendo cada sector de la escena bajo su propia fuente y eligiendo cual ponderar al momento de exponer o representar en el display.

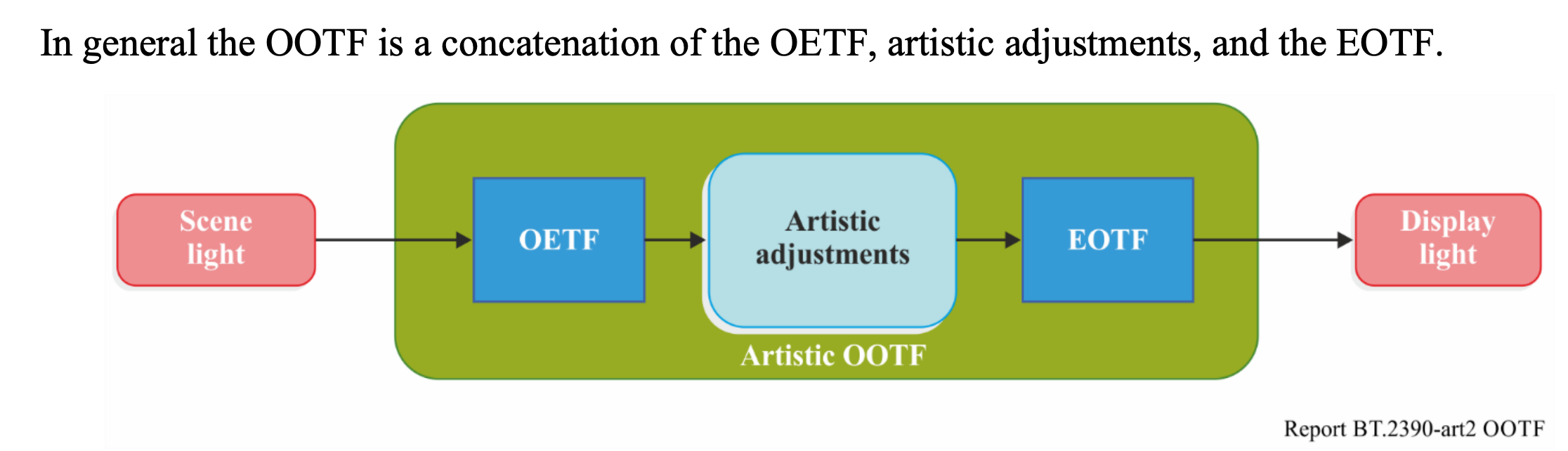

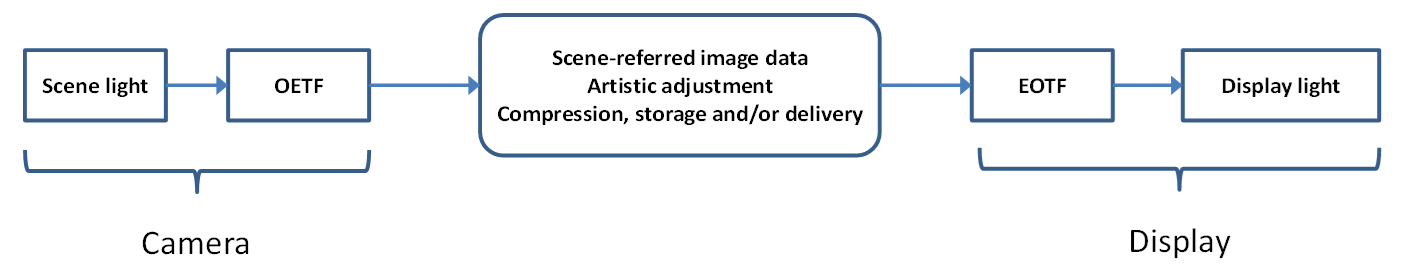

OOTF

Tanto en el papel como en el display, sea este una proyección en pantalla de cine o en un TV, los stops fotográficos se representan de manera comprimida, excepto en algunos casos donde una escena de poco rango dinámico sea capaz de reproducirse en stops de representación, o de display.

Esto establece una relación de luz de escena con luz de display, o bien una relación opto-óptica, la cual rara vez se representa de forma lineal.

Con la llegada de la digitalización de las señales eléctricas, la relación analógica del efecto fotoeléctrico, la cual es de proporción lineal, puede ser almacenada con una codificación lineal. La codificación es ese paso de un valor de señal eléctrica a otro a otro valor definido bajo una transformación matemática, en donde una variable se convierte en otra a través de una función.

Esa función puede establecer una relación opto-eléctrica no lineal, lo cual no modifica en absoluto al efecto fotoeléctrico, sino más bien en la relación de luz ya convertida por la eficiencia cuántica del sensor en electricidad, y esta electricidad volcada a una señal que se distorsiona al codificarla en valores binarios. Por lo tanto la codificación de la señal digital (y no la señal en estado analógico que aun guarda proporcion lineal con la luz) puede utilizar una función matemática que altere su relación “opto-eléctrica”, lo cual sería ideal expresar con un término más esclarecedor: función de transferencia “opto-valor de código”, lo cual en inglés quedaría horrible lamentablemente.

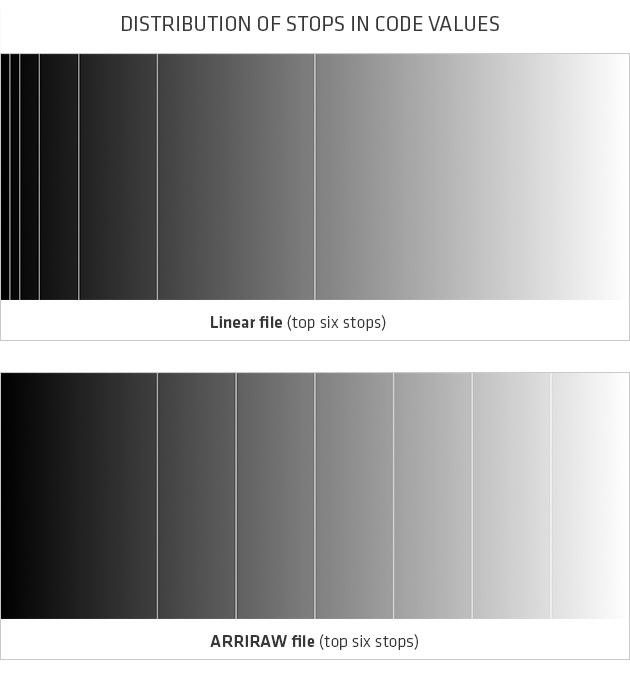

Las OETF son entonces funciones para no guardar la relación lineal del efecto fotoeléctrico en valores de código lineales, ahorrando así muchos valores gracias a representar a cada stop fotográfico con una cantidad similar de valores de código.

ARRI incluso en su formato ARRIRAW utiliza la codificación OETF del LogC4 para así poder guardarlo en apenas 13 bits, en vez de necesitar 18 bits lineales debido a su rango dinámico de más de 17 stops.

Dependiendo del rango dinámico de un sensor, existirán OETF diferentes para almacenar cada uno, en donde dentro de una función de operaciones mixtas, hay una que se distingue que es la logarítmica, la cual es la inversión de una escala exponencial, como las utilizadas para definir por ejemplo el tiempo de exposición. Cada paso logarítmico define la mitad de valores de código a medida que la luz aumenta sus valores fotométricos de candela por metro cuadrado o NIT exponencialmente, lo cual es ideal para expresar con la misma cantidad de valores a cada paso o "stop" fotográfico.

Estas codificaciones luego serán totalmente reversibles, pues así como exponente es el inverso de Log, la multiplicación encontrará su inverso en la división, y la suma en la resta.

La palabra codificación o encoding lo dice todo: la imagen de la escena está codificada y hará falta decodificarla para volver a ella y operar sobre un espacio de trabajo de codificación lineal, típicamente para tareas de CGI y Compositing, o bien a una codificación Log-based como ACEScct, T-Log, DaVinci Intermediate o directamente sobre la codificación OETF de cámara.

Por su lado la curva sensitométrica, la cual puede parecer en un gráfico como una función, no es en realidad “invertible”, pues no nace de una función matemática que tenga complementos. Ya no hay manera de volver a la linealidad, o sea a una representación proporcional entre la opacidad y la luz de la escena.

Por esto mismo la insistencia de considerar a la codificación “una imagen sin revelar”, o bien el Raw considerarlo así es un error conceptual. Pero al mencionar al Raw, algo dentro del proceso de conversión a display deberá aplicarse, de manera similar a lo que sucede de manera espontánea en el proceso fotoquímico, que es la compresión tonal.

Render

Y aquí aparece el gran concepto perdido en el camino, pues este eslabón de la cadena suele ocultarse bajo el concepto marketinero de la “ciencia del color” de los fabricantes de cámara.

La ciencia consiste en describir lo que sucede en la naturaleza, como Einstein pudo describir al efecto fotoeléctrico. No lo inventó, sino que pudo explicarlo bajo la singular belleza de la lengua matemática, el lenguaje favorito de la expresión científica.

El Render es un término que para hispanoparlantes puede evocar ideas bastante confusas. Yo elijo traducirla como el Plasmar una imagen en el dispositivo de reproducción, sea una pantalla, proyección en lienzo o en papel, como también un artista plástico puede plasmar una imagen en un lienzo o papel.

Este plasmar tiene el desafío de representar el detalle, y para sistemas de reproducción de poco rango dinámico, suele elegirse el comprimir valores de "especulares" para así desplegar el rango de claridad, o sea de reflexiones difusas de la escena en valores con detalle.

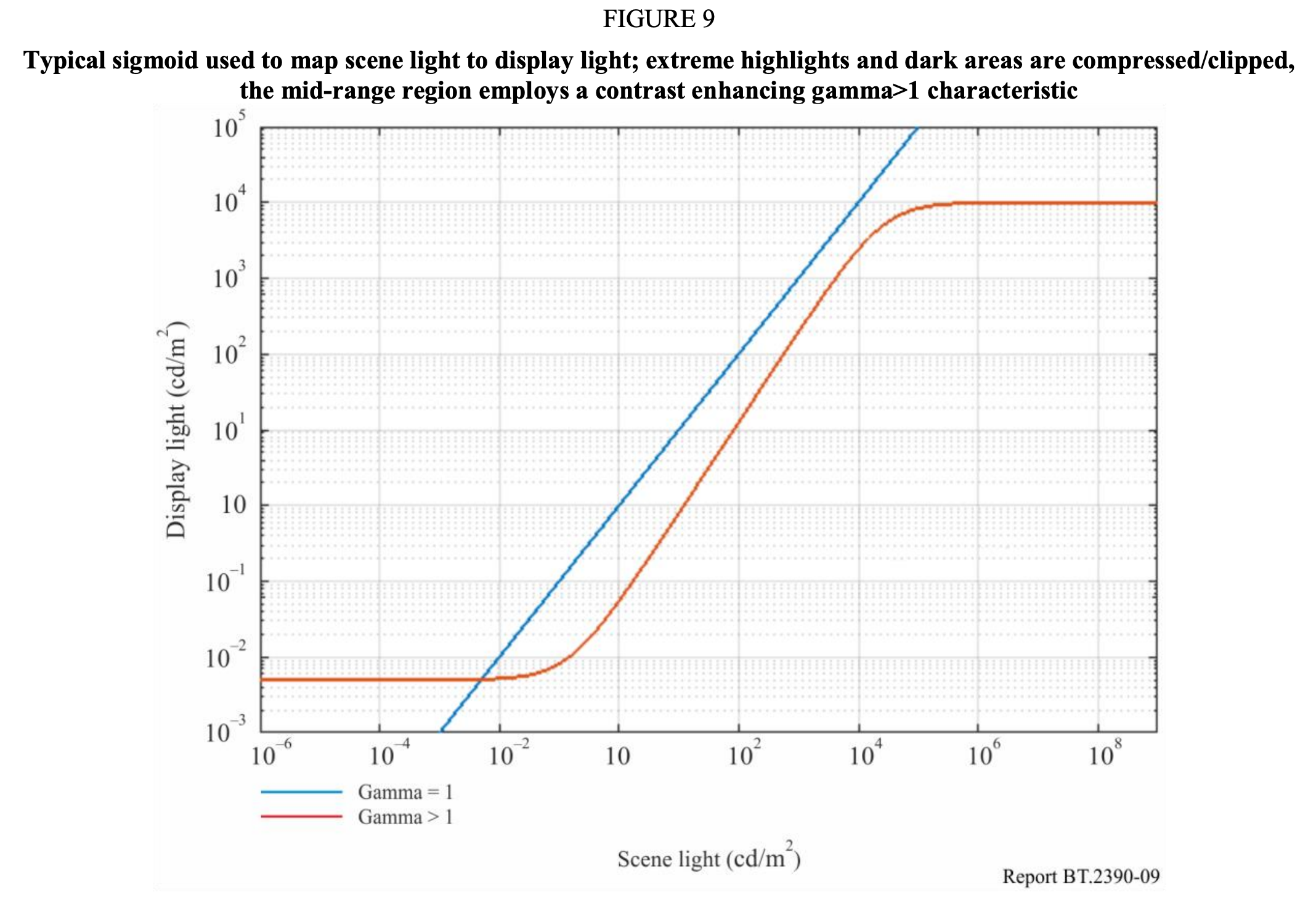

El gran rango dinámico capturable por las cámaras digitales modernas que hoy alcanzan hasta 17 stops, necesitan de una compresión tonal al representarse o hacer “render” en un display. Eso se suele conseguir a través de una función sigmoidal, o función en forma de letra ese, de manera tal de comprimir tanto las primeras y últimas zonas en el display.

En el proceso fotoquímico eso sucede naturalmente puesto que tanto el positivo y el papel tienen su curva característica que resulta en una forma sigmoidal, el famoso toe & shoulder fotográfico.

En el digital, esta función hay que agregarla matemáticamente, a través del rendering.

En ACES, la Reference Rendering Transform o RRT es la encargada de comprimir el contraste con una función sigmoidal, la cual se está revisando para la version 2.

ARRI posee su propio render, el cual estaba adherido a la transformación a display, la cual su manera clásica era la curva k1s1, una manera de enumerar la primera opción de knee y shoulder artificial para encajar el gran rango dinámico de manera comprimida a un display.

Sony ha imitado este rendering definiendo una conversión 709-A, una función para ir a la normativa 709 al “estilo Alexa”, y de allí la letra A.

RED definió un término bastante confuso que son “opciones de gamma” como el gamma3, gamma4… lo cual incluye mapeos tonales al convertir a display.

Toda la gama de Gammas

En TV, la función gamma es la que define una función exponencial para codificar la señal, pero este exponente es igual a 1 dividido un valor, el cual es el valor gamma. Por lo que un gamma 2 es igual a un exponente 0.5, o sea elevar a la potencia 1/2.

Como ya deberíamos comprender, el sistema sensorial humano no tiene una respuesta lineal a los estímulos, cualquiera sea, y es por ello que no conviene desperdiciar la pequeña señal de apenas un voltio de amplitud en valores que distinguiremos muy poco.

Los milivoltios de la señal no deben equivaler a la luminancia a emitir en la pantalla del tv, sino a las “sensaciones de brillo”, y una forma rudimentaria de describir matemáticamente esas sensaciones es a través de las funciones exponenciales.

La TV aplicará un exponente a la señal, cercano a 2 (2,4 para ser exactos), o sea multiplicará el valor de la señal eléctrica por sí misma, elevandola al cuadrado (un poco más, ya lo sabemos) antes de convertir la electricidad en luz, recuperando así la “linealidad” en la transformación electro-óptica.

La codificación del display es entonces a través de una EOTF, una función gamma que se deshace en el display por el built-in gamma que es un exponente del mismo valor que gamma, el cual esta vez no divide a uno, resultando en deshacer la codificación: decodificando.

Tanto la OEFT y la EOTF se deshacen en los extremos de las cadenas Opto-ópticas.

Dentro de estos extremos, el eslabón crucial es la plasmación a display, que le da nombre al Display Rendering Transform o DRT, o bien la RRT, o bien el mapeo tonal que queramos definir como “stock digital”, pero de copia y nunca de registro, pues en digital siempre el original es el efecto fotoeléctrico.

Y es por ello que no tiene sentido alguno intentar encontrar algo significativo en una codificación, sea EOTF, OETF o cualquier otra: todas se deshacen.

El sistema zonal de Adams se preocupaba por el rango de claridades, el cual hoy es directamente visible incluso en el display SDR, y gracias al mapeo tonal podremos elegir cómo comprimir especulares y oscuridad total.

El sistema zonal nos puede seguir sirviendo para imaginar escenas a representar en pantallas de cine (SDR), y ya no copias en papel, sin necesidad incluso de tener fotómetro en mano.

Pero hoy en día contanmos con un nuevo reproductor de imágenes de alto rango dinámico, el cual nos pone en la situación de repensar cómo se hace el rendering, el rol del detalle y su rol en la narrativa visual.

Fuentes:

Reporte ITU-R BT.2390-5

Teledyne FLIR

Ansel Adams - El Negativo

ARRI.com

Kodak.com

ACESCentral.com

Querés estudiar para ser un gran DIT? Escribí a atelierxxxx@gmail.com por cualquier consulta!