Blog

La respuesta no será teórica, sino práctica:

Simplifica.

El rango dinámico y gamuts de cámaras supera lo reproducible por los monitores. Y tanto fotógrafos como coloristas, queremos trabajar con toda la información nativa y no sólo con lo que un Display podría reproducir. Es por ello que el espacio de trabajo Display Referred es un compromiso, puesto que en este flujo lo capturado se convierte a lo reproducible, lo cual equivale a una información mucho menor.

Los espacios de trabajo Scene Referred conservan toda la información nativa de la escena capturada, y ACES es un espacio de trabajo capaz de almacenar todo lo comprensible por el sistema visual humano, rango dinámico y gamut mayor que lo que cualquier cámara puede llegar a capturar.

El comportamiento de los algoritmos de color variarán según el espacio de trabajo, y para realizar corrección de color existe una variante cc de ACES, la cual es similar al espacio logarítmico, muy familiar para los que realizaron trabajos en ecosistemas de Digital Intermediate (DI) vía Kodak Cineon. Las funciones de grading para cine ya no son las clásicas de video, como Lift Gamma Gain (LGG), siendo reemplazadas por Offset, Contrast y Pivot.

En DVR, las funciones “Log” para trackballs son las indicadas para ACEScc.

Esto suele incomodar a coloristas que sienten que en su oficio ya han aprendido todo, y resulta que el trabajo que tan bien realizan con LGG - conocido como Telecine Style - en ACES no obtiene los resultados que esperaban. Simplemente deberán migrar al DI Style.

Superado este punto, ACES simplifica el intercambio entre aplicaciones de color o de VFx, gracias a que esta administración color es de código abierto lo cual facilita su soporte por casi la totalidad de desarrolladores de software, y gran cantidad de fabricantes de hardware.

ACES es gratis, cualquiera lo puede soportar.

No sólo por ser gratis es ventajoso, sino que además su desarrollo es público. Desde un foro abierto se definen grupos de trabajo para poder proponer futuras mejoras al sistema.

Al leer un archivo de cámara, este se transformará primero a ACES para luego transformarse a un estandar de visualización, asegurando la continuidad en la monitorización calibrada.

El punto de partida para el fotógrafo será entonces el mismo que consigue en la monitorización de campo, iniciando el Grading con el colorista desde esta referencia inicial.

El departamento de VFx podrá recibir archivos previamente volcados a ACES, manteniendo el total de datos originales de cámara sin necesidad de adivinar cual es la representación correcta de este archivo exr. El balance del colorista puede aplicarse en el espacio ACES sin pérdidas, o bien exportar como metadatos este balance a un compositor de tal manera de que la composición sea realizada sobre la imagen nativa, previa al balance pero monitorizada con el balance aplicado.

La ida y vuelta o Roundtrip de VFx ahora es perfecta.

El paso final del grading, el cual consta de los ajustes de masterización para diferentes tecnologías de Display SDR y HDR se facilita en ACES debido a que el color se ha realizado sobre un espacio total, visualizando a través de una transformación relativa hacia un determinado Display. Al modificar la salida hacia un Display con un estandar diferente obliga al colorista a realizar un pequeño ajuste o Trim Pass, con el objetivo de evitar pérdidas de detalle en estándares de menor gamut o rango dinámico, pero sin necesidad rehacer el Grading por completo.

Recapitulando, ACES facilita la monitorización, el punto de partida del grading, la compatibilidad entre aplicaciones, el roundtrip con VFx y el proceso de multimastering.

Desde las Bellas Artes, la realidad es representada reduciendo sus cualidades originales, facilitando la comprensión de esta realidad gracias a carecer de algunas de sus dimensiones. La escultura no posee movimiento, o muchas veces color. La pintura carece de tridimensionalidad y tiempo, la música de dimensiones visuales, así como el relato, el cual sólo necesita del tiempo y carece de lo demás, haciendo aparecer estas dimensiones en la imaginación del escucha. Y si el relato es escrito, ni siquiera poseerá un tiempo y tono de voz predefinido. Todo lo generará el lector.

A medida que la realidad se estructura bajo elementos más sencillos, el reconocimiento y organización de estos elementos da lugar a la experiencia estética.

La imagen cinematográfica, la cual retrata lo visual en movimiento, se instaura dentro de las artes clásicas dejando una impresión heredada por su soporte y por la forma tradicional de ser vista.

Aunque existen nuevas tecnologías de imagen que permitieron superar en calidad a sus antecesoras como nuevos métodos de visualización de mayor definición, mayor contraste y paleta, otras características siguen prevaleciendo por encima de cualquier ventaja o avance tecnológico aparente. Estas características, que pueden incluso interpretarse como imprecisiones o caprichos técnicos del cine, las denominaré como “características cinematográficas tradicionales”.

Estas son apenas seis: Grano (grain), entorno oscuro (Dim), blanco cálido (D60), tironeo (judder), mapeo tonal (tone mapping), y reproducción color preferida (preferred color reproduction).

Grain

El cine hereda de la fotografía una emulsión con granos sensibles a la luz, los cuales poseían cierta irregularidad en su sensibilidad. Los sensores modernos no utilizan emulsiones, pero poseen fotositos que registran valores con diferencia aleatoria, o ruido. Tanto el ruido del píxel activo como la variación aleatoria del grano no cuenta a la historia en sí misma, percibiendo a esta variación aleatoria de la imagen en un plano perceptual diferente al de la proyección. Sin embargo su ausencia puede apreciarse como carencia de una característica formal del cine.

La forma del ruido electrónico no es equivalente al grano, el cual posee otra forma y contraste. Aunque no era un efecto deseado, muchos realizadores siguen definiendo como característica imprescindible del cine al grano, el cual muchas veces agregan sobre la imagen digital. Otros prefieren una imagen más limpia de irregularidades, y por ello este aspecto del cine es el más discutible.

Dark Surround

La imagen de cine fue visualizada originalmente a través de sistemas de proyección de luz sobre pantallas blancas. Para obtener una imagen con cierto contraste hacía falta visualizarla con un entorno lo más oscuro posible, de tal manera de minimizar la iluminación de la pantalla por otras fuentes de luz que no provenga de la propia proyección. El mobiliario de la sala, así como las paredes, techos y suelo debían entonces reflejar poca luz, siendo oscuros para así minimizar la reflexión de la luz que proviene de la propia pantalla. Todo esto define entonces un entorno de visualización muy oscuro.

Pero las pantallas emisivas de la televisión permiten entornos de iluminación tenue o incluso brillante. Este entorno, el cual ocupa una porción muy grande del campo visual periférico, altera la percepción de la zona central del campo visual. Cuando el cine es visualizado en ese contexto, la apariencia de la imagen varía considerablemente. Los espectadores comenzaban a ver programas de tv en donde se televisaba contenido destinado a pantallas de cine desde los salones de sus casas, los cuales poseen algo de iluminación y esto atenta contra el objetivo artístico de la obra. En general estos ciclos de cine se programaban por la noche, pero la aparición de la tv por cable agregó la posibilidad de ver películas de cine a toda hora. Y bajo cualquier entorno de visualización.

Con los sistemas de visualización on-demand de contenido de cine, el espectador podía elegir el horario para ver determinado contenido. El concepto de Home Theatre también agregó cierta facilidad a los que desarrollaron un paladar por la visualización del cine, los cuales lentamente recuperaron el entorno de visualización oscuro adecuado.

Paradójicamente otras tecnologías como las pantallas portátiles LCD TN, o celulares, trajeron nuevas formas de visualizar contenido. Pero todos lo sabemos: el cine “cine” debe verse grande y a oscuras.

El nuevo HDR posee dos formas elementales. Una está destinada para visualizar televisión. Noticias, deportes, eventos, son considerados productos de TV. La otra forma está destinada al cine, donde existe un objetivo artístico (creative intent), el cual será alcanzado únicamente si el entorno de visualización del espectador es oscuro.

D60

La mezcla de los colores rojo, verde y azul con los que se sintetizan los demás colores, en su máxima potencia deberán producir una sensación de color blanco. Pero este blanco puede tender sutilmente a un color. Este blanco tiene una correlación con una temperatura en grados kelvin (CCT). El estándar D60 define un iluminante similar a 6000K. Este iluminante fue el color blanco aproximado de las lámparas de arco de carbón, utilizadas por décadas en los proyectores de cine. Sin embargo la televisión posee un estandar con iluminante D65, lo cual equivale a la luz diurna promedio de europa, resultando en algo similar a 6500K. Este iluminante tiende más al azul, a diferencia a la lámpara de arco de carbón que es rojiza.

Los proyectores de cine digital utilizan lámparas de gas de xenón, la cual genera un tono verdoso. Este color de blanco no es agradable, sobre todo luego de años de costumbre de que el cine posee un D60.

Los TVs suelen poseer un modo de visualización “cinema”, el cual emula el D60 en un TV que posee un blanco D65. La tradición del cine impone entonces que cuando no haya saturación alguna, los colores neutros tiendan al cálido. Sin embargo esta asunción se puede ignorar, utilizando como referencia el D65 y el espectador, debido a la adaptación cromática, terminará por compensar esta diferencia a los pocos minutos de visualización, gracias a que el entorno oscuro no permite distinguir ninguna referencia externa a la pantalla.

Aún así el D60 se sigue prefiriendo como “punto blanco” del cine.

Judder

Aunque el estándar de cine digital DCI permite cadencias de 48 imágenes por segundo, lo cual brinda una resolución temporal muy superior a los 24 cuadros tradicionales, esta mejoría genera cierto rechazo en la mayoría de los espectadores.

Debido a que la dimensión del tiempo se retrata con mayor fidelidad, muchos espectadores comienzan a tomar una postura crítica sobre el relato fantástico que le es brindado en la pantalla. Así como muchos espectadores no toleran el teatro, pues les insume mayor compromiso con el contrato artístico, debiendo renunciar a la verosimilitud de la calidad de construcción del decorado, las elipses temporales que pretenden los apagones de luz y cambios de escenario, el logro en el vestuario y maquillaje, cuando el cine es HFR estos espectadores comienzan a observar críticamente la calidad de las actuaciones, del maquillaje, e incluso de la verosimilitud del relato, pues la incredulidad no se suspende tán fácilmente con algo tan real enfrente.

Las encuestas al público luego de ver una película en versión HFR (high frame rate) trajeron resultados sorprendentes: la mayoría consideraba a la película poco lograda. Sin embargo la misma película para espectadores en versión 24P la consideraron excelente en su gran mayoría.

Es por esto que el tironeo clásico de los 24P juega un papel hasta positivo en la obra cinematográfica.

Tone Mapping

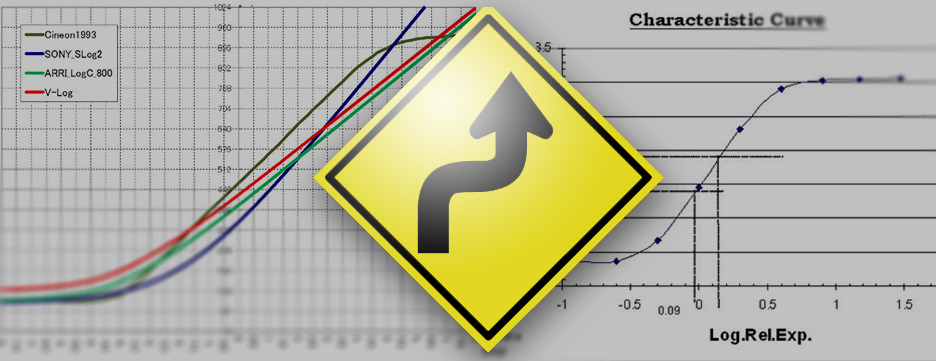

Tanto el negativo como el positivo poseen una respuesta no lineal al estímulo lumínico. La película traza en el gráfico que opone el tiempo de exposición con la densidad lograda, una “curva característica” la cual inicia con un talón (toe), continúa en una línea recta (straight line) y termina su forma con un hombro (shoulder). El fotógrafo deberá exponer de tal manera que la imagen válida genere detalle en la línea recta. Pero el talón y hombro quedarán de todas maneras registrados como valores adicionales, lo cual le otorga al fotógrafo cierto margen de error en la exposición que podrá ser utilizado al momento de copiar el negativo. Esta copia de laboratorio revierte nuevamente la imagen, transformando la imagen en positivo, haciendo que lo denso sea transparente y por donde la luz del proyector pasará líbremente.

Pero el positivo utilizará todo su rango dinámico, haciendo que la curva tonal positiva registre con su talón y hombro de forma distorsionada esta relación de contraste. Sin embargo esta curva tonal resultante es muy agradable a la visión humana, puesto que brinda detalle en las zonas oscuras y claras, debido a que registra lo oscuro más claro, y lo claro más oscuro. Esto facilita al observador el distinguir texturas en lo brillante y en lo oscuro. Si estas zonas no presentaran detalle, el iris del ojo humano cambiará el diámetro pupilar infructuosamente en búsqueda de mayor detalle.

El video no fue desarrollado con esta característica, por lo que las compensaciones de la respuesta lineal de los sensores hacia los displays no poseen intrínsecamente este acomodamiento del rango tonal. Esto genera una diferencia muy evidente entre una imagen electrónica y otra de cine analógico. Para mimetizar esta respuesta, se deberá entonces imitar el mapeo tonal, realizando en la etapa de grading el proceso de Tone Mapping.

Preferred Color Reproduction

La película positiva también posee características que de alguna manera maquillan la imagen retratada. Este maquillaje elimina diferencias de color en algunos tonos que los seres humanos en general prefieren retratar de manera homogénea.

Si imaginamos unas fotos de vacaciones, seguramente compartiremos las fotos que mejor retraten los días más felices de nuestra corta estadía en compañía de la naturaleza.

Uno de los colores maquillados es el del cielo, el cual suele considerarse más hermoso cuando es de un azul vibrante, despejado de toda nube. Otro es el color verde de la vegetación. Si este color se reproduce pálido entonces podrá parecernos una vegetación menos saludable y atractiva. Y el más importante de los colores, el de la piel humana, el cual se prefiere homogéneo, sin manchas de color y con cierto grado de saturación y tendencia a un color idealizado. Estos tres colores corresponden a los cuatro primeros casilleros de la carta Macbeth, lo cual ofrece una idea de la importancia de estos colores principales.

Más allá de subjetividades menores, las encuestas dan siempre como ganadoras a las fotografías con estas características vibrantes y saludables, aunque bastante maquilladas.

Kodak desarrolló películas que consiguen partiendo de una variedad de imágenes, una misma reproducción color homogénea e idealizada, lo cual la hizo la película favorita de los aficionados. El cine tampoco es la excepción, y esta reproducción color preferida sigue siendo una de las características fundacionales del cine.

Así que cuando hagamos valoraciones cinematográficas podríamos estar refiriéndonos a un condicionamiento proveniente de una larga tradición.

La relación entre la magnitud física que provoca un estímulo y la respuesta sensorial obtenida nunca posee una proporción lineal. Ya fue estudiado por Weber, y reformulada por Fechner en forma de Ley científica, en el siglo 19. Para simplificarla, podría decirles que la Ley establece que la primera copa que bebamos no producirá el mismo efecto que la décima.

Cineon fue una codificación desarrollada por Kodak para no guardar datos binarios obtenidos por el escaner de película donde el stock fotográfico no poseía respuesta alguna. Esto sucedía debido a que el haluro de plata del stock era desarrollado para poseer una respuesta no lineal similar al sistema visual humano, y la codificación cineon lo que permitía era eliminar datos de la respuesta lineal del sensor electrónico del escaner, resultando en la reducción del archivo original de 16 bits en un archivo de apenas 10 bits sin sacrificar calidad alguna.

El efecto fotoeléctrico, el cual permite al sensor electrónico del escaner o de una cámara transducir fotones en señal eléctrica, sí posee una proporción lineal. Por lo que todo sensor internamente se vale de una respuesta lineal al estímulo. Entonces a diferencia del cine analógico, en una cámara de cine digital estos datos de luces altas sí existen. Esta respuesta puede almacenarse de manera cruda en un archivo Raw. Este archivo grande y absoluto, al no coincidir con la respuesta no lineal del sistema visual humano distribuirá gran cantidad de datos en los tonos que consideramos muy brillantes y muy poquitos datos en los oscuros.

Sin embargo existen métodos para reducir esta inequidad entre las luces altas y las bajas, modificando la relación original entre lo óptico (luz) y lo eléctrico (señal), a través de una función matemática de transferencia: Opto-electrical Transfer Function. OETF.

Estas funciones de alguna manera redistribuyen los bits entre los stops captados por la cámara, lo cual posibilita guardar el gran rango dinámico de la cámara en un contenedor de sólo 12 o 10 bits. Son las denominadas codificaciones Log, como S-Log, V-Log, Log-C, C-Log, D-Log y otras que son mencionadas con el adjetivo film, como el anterior RedLogFilm, reemplazado hoy por el Log3G10, o el FilmGamma de BMC. Todas estas codificaciones deben deshacerse con las funciones opuestas o OETF -¹ antes de comenzar a trabajar sobre ellas.

Por otro lado poseemos dispositivos de reproducción electrónicos, los cuales deberán establecer una relación inversa entre la señal y la luz emitida resultante, estableciendo una función de transferencia electro-óptica, o EOTF. En el caso de los displays de rango dinámico estandar, una función matemática de transferencia exponencial en vez de logarítmica es suficiente para que la señal almacenada haga su transducción a luz de manera coherente. Esta función exponencial se denomina Gamma.

Entonces Gamma y Log son funciones matemáticas que sirven para acomodar valores dentro de rangos dinámicos estándares o extendidos. Gamma 2,2 o 2,4, incluso 2,6 son valores utilizados para convertir electricidad en luz en pantallas de computadora, TVs SDR o proyectores de cine SDR. La mayoría de las funciones de transferencia son mixtas, esto quiere decir que poseen porciones del rango dinámico codificadas en partes lineales, exponenciales y logarítmicas. Es por ello que a veces conviene llamar a las OETF con sus letras S (Sony) V (Varicam) C (Canon o si está al final, “tipo Cineon” de ARRI) y no “Log” a secas, pues son funciones compuestas y no puramente “Log”. Lo mismo sucede con sRGB que puede parecer gamma 2,2 pero en realidad es una combinación de una porción de codificación lineal con una codificación gamma 2,4. La decodificación hacia los flat panels es conocida como BT.1886 e internamente es un gamma 2,4 exacto, paradojas del argot técnico.

El HDR debido a que expresa un rango dinámico enorme en una señal de de apenas 10 o 12 bits también utiliza codificaciones híbridas, como el HLG (Hybrid Log Gamma) o el PQ (Perceptual Quantizer, o ST.2084).

Pero entonces, qué quieren expresar esas “Curvas” opcionales de cámaras, como las Cinestyle, Cinelike D, V, o el RedGamma4, estas son también codificaciones que luego se deshacen antes de comenzar a trabajar? Son maneras de obtener mayor latitud de la cámara en un contenedor de video?

No!

Son funciones matemáticas, las cuales en un eje cartesiano expresarían una curva la cual intenta ser similar a la curva sensitométrica pero del positivo, y no imitar la respuesta del negativo.

Para qué se utilizarían entonces? Para realizar una corrección de color en cámara, de manera tal de poder grabar en un contenedor de video de 10 u 8 bits una imagen procesada desde el sensor que nos brinde detalles en bajas y altas, de manera similar a lo que realizaba la copia positiva con su curva sensitométrica. Este proceso, realizado con herramientas de corrección de color digitales se denomina Tone Mapping.

Este resultado es agradable a la vista, pues de alguna manera emula lo que realiza involuntariamente el músculo del iris en el ojo humano, el cual es capaz de acomodarse rápidamente permitiendo ver un stop extra en lo claro o oscuro, variando el diámetro pupilar en tiempo real. Esta búsqueda de detalle se encuentra más saciada cuando la imagen visualizada posee detalles suficientes en lo oscuro y lo claro, lo cual puede conseguirse con una “curva en forma de letra Ese”.

-

Los modos de grabación “Standard” suelen referirse a codificaciones de estándares como HD Rec.709 o UHD Rec.2020, de rango dinámico estandar o SDR.

-

El video HDR se codifica bajo la Rec.2100 con HLG o PQ, ambas con los primarios 2020 del UHD.

-

Los modos de grabación “Log” se refieren a convertir la señal lineal a una OETF que permita guardar los primarios nativos de cámara en contenedores de 10 o 12 bits.

-

Los modos Cine se refieren a características de la imagen cinematográfica respecto a la apariencia o “look”, los cuales son agradables a primera vista. Se refieren más al positivo que al negativo.

Pero así como la película positiva, los modos “Cine” no son modos de grabación que brindan una latitud extra, sino que se trata de un Tone Mapping realizado en tiempo real por la cámara, pero partiendo del “readout” HDR del sensor. Es entonces sólo una buena alternativa para cuando no se pueda grabar archivos mayores que 8 o 10 bits, los cuales tienen más limitaciones para portar codificaciones Log.

Así que cuidado con las curvas peligrosas!

Desde que comprendí administración de color, me dí cuenta de una mala praxis acerca de cómo trabajaba archivos con codificación logarítmica, como Log-C, S-Log y otras. Y también la mala interpretación que hacía al leer archivos Raw.

En general suponía erróneamente que la codificación Log había que deshacerla manualmente, por lo que el punto de partida del trabajo de color era ese material “lavado” “chato” “sin contraste y saturación”.

No suponía además que ese material poseía colores primarios que no necesariamente eran los primarios RGB de mi monitor HD, sino otros muy diferentes, los cuales definen el gamut nativo de cámara.

El error recurrente y muy propagado en ámbitos profesionales, e incluso canales de youtube que enseñan este proceder incorrecto, es el de realizar una corrección “manual” sobre los valores Log, utilizando una curva o ajustando gamma y otros valores de corrección directamente sobre el material. De esta manera se pierde el gamut nativo y además se interpreta de manera incorrecta la exposición original.

Al utilizar espacios de trabajo Display Referred, como proyectos o timelines Rec.709, existe la opción de realizar la transformación del material con funciones matemáticas como en Resolve el OpenFX “Color Space Transform”, desde el cual puede definir como entrada el color nativo y codificación del material, para así convertirse al espacio del timeline.

En Scratch es un poco diferente, pues la aplicación puede cambiar de espacio de trabajo por evento de edición, de manera que en un mismo timeline pueden coexistir diferentes espacios de trabajo como ACES, o bien P3, 2020, 709, etc. Los settings de Scratch se realizan desde el menú Media/Data Format.

Los que trabajamos con Mistika o Baselight puede que tengamos más clara la administración color, pues es mucho más explícita que en otras plataformas.

Al implementar ACES como administrador de color, simplemente seleccionando como IDT la codificación de cámara y gamut, se convierte el material hacia ACES, el cual vuelve a convertirse hacia 709.

En el caso de archivos Raw esta identificación no suele ser necesaria gracias a los metadatos del Raw.

A veces a primera vista la conversión puede parecer sobreexpuesta, y esto se corrige o bien desde el valor ISO del Raw, o bien para archivos Log desde la corrección de color modificando Offset. De esta manera se vuelca el alto rango dinámico de manera adecuada hacia el rango dinámico del display que estemos utilizando, aprovechando así la diferencia entre estos rangos, lo cual da lugar a la “latitud” que es ese margen de diferencia corregible entre el rango de la captación original y el rango de visualización, siendo este segundo un rango menor.

Los archivos Raw, al leerse en proyectos Display Referred por ejemplo un timeline 709, permiten reinterpretar el media desde el propio decodificador, el cual posibilita la transformación a 709. Este sería entonces la manera “justa” de iniciar el grading en el caso de elegir este pipeline de color basado en la posibilidad de reproducción del Display. Otros espacios de salida estarán disponibles, de tal manera que el propio decoder Raw realice las transformaciones a otros espacios de trabajo con diferentes gamuts y diferentes valores “gamma” (término confuso, pues en realidad la función de transferencia no es sólo una función meramente exponencial, sino casi siempre mixta), pero estos parámetros se inhiben en el decoder al utilizar administración de color desde la aplicación, por lo que la codificación lineal del Raw se vuelca junto a su gamut nativo hacia el espacio de trabajo.

Síntoma de la incomprensión de la administración de color es el famoso demo reel del colorista que muestra un “antes/después” donde el antes es la codificación Log. Esto supone que la decodificación Log no la realiza con la transformación opuesta correspondiente (-OETF), sino que deshacer el bajo contraste aparente de la codificación Log supone una pericia del propio colorista, lo cual es un error conceptual.

Este error común es fácil de subsanar, comprendiendo cómo utilizar las herramientas de administración de color incluidas en todas las aplicaciones de grading.

Edi Walger - ColorDoctor